Le projet HUMAR

Reconnaissance de l’activité humaine pour l’interaction homme-robot (HUMan Activity Recognition)

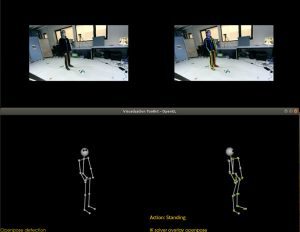

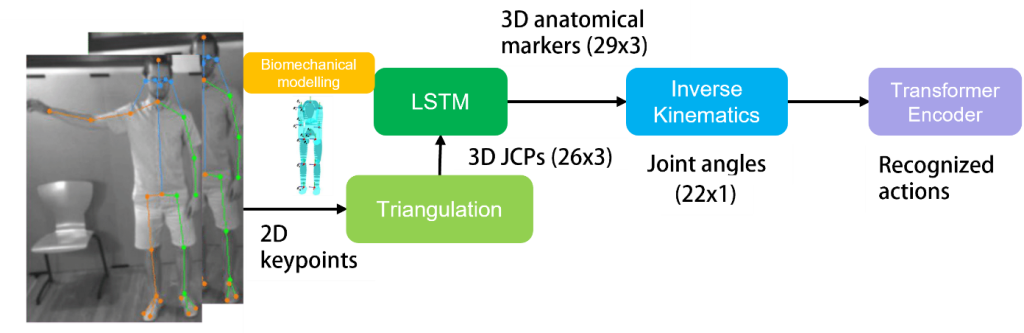

Pour assister les opérateurs industriels, nous combinons vision par caméra, apprentissage profond et grands modèles de langage afin de reconnaître les gestes industriels, prédire les intentions humaines et contrôler un robot collaboratif. Cette approche permet une interaction plus fluide et contextuelle entre humains et robots en milieu industriel.

Objectifs

- Développer une librairie logicielle pour la perception visuelle et la classification, en temps réel, des activités d’un humain pendant qu’il/elle interagit avec un robot.

- Prédire le geste de l’opérateur à partir d’une posture courante en utilisant de l’apprentissage par renforcement inverse.

- Exploiter la librairie dans le cadre de la thèse pour permettre une collaboration humain-robot efficace dans le cadre de l’industrie 4.0.

Résultats attendus

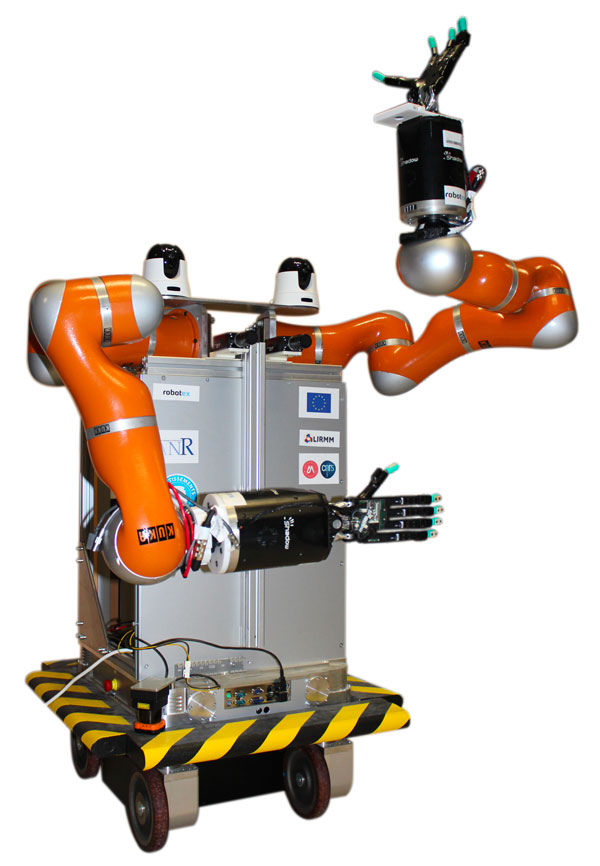

A la fin du projet HUMAR, nous proposerons un démonstrateur, incluant un robot manipulateur mobile interagissant avec un ou plusieurs humains dans le cadre d’un scénario de type ‘usine du futur’ : le robot assistera de manière autonome les humains, en les libérant de certaines taches (par exemple : transport d’objets) et en synchronisant ses activités avec celles des humains. Du point de vue technique le doctorant fournira une boîte à outils open-source pour la reconnaissance et la prédiction d’activités humaines.

Type de financement

Thèse

Doctorante recrutée

Wanchen LI

Référents

Andrea CHERUBINI

Vincent BONNET

Robin PASSAMA

Sofiane RAMDANI

Mots-clés

Robotique

Vision

Biomécanique

Apprentissage Profonde

Grand modèle de Langage

Dates

01/01/2024 au 31/12/2026

Tutelles

Université de Montpellier

Tutelles partenaire

LAAS-CNRS

Partenaire

IPAL Singapore

L’équipe

Robin PASSAMA

IngénieurLIRMM

Développement logiciel

Les posters